Table des matières

Open WebUI est une plate-forme ouverte auto-hébergée qui vous permet d’exécuter des modèles de langage AI sur votre propre machine avec un contrôle total sur vos données. Il prend en charge des modèles locaux comme Olllama ainsi que des API compatibles OpenAI. Vous pouvez auto-hoster ouvrir webui à l’aide de Docker, Python ou Kubernetes. Ici, nous allons montrer un processus étape par étape pour installer Open WebUI sur votre machine locale.

Pourquoi utiliser Open Webui?

Open WebUI vous offre un moyen facile et flexible d’utiliser l’IA sur vos termes. Il prend en charge différents modèles d’IA et fonctionne sur tout système d’exploitation majeur. Il dispose d’une interface de style CHATGPT propre, offrant des fonctionnalités telles que Markdown, le latex, les plugins et un système de mémoire intégré pour stocker du contenu utile.

Vous pouvez intégrer les plugins, connecter des API et gérer plusieurs chats à la fois. De plus, vous pouvez enregistrer des invites pour garder vos meilleures idées prêtes à l’emploi. En tant qu’outil open-source, il évolue rapidement avec les contributions de la communauté, en vous assurant toujours d’avoir accès à de nouvelles fonctionnalités et améliorations.

Installer Open WebUI

Pour installer Open WebUI à l’aide de Docker, vous devez d’abord configurer un répertoire de projet, puis y accéder:

mkdir openwebui

cd openwebuiMaintenant, créez un fichier «docker-compose.yml» dans n’importe quel éditeur comme le bloc-notes:

nano docker-compose.ymlCollez le contenu suivant dans le fichier «docker-compose.yml»:

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

ports:

- "11434:11434"

environment:

- OLLAMA_USE_GPU=false

volumes:

- ollama_data:/root/.ollama

restart: unless-stopped

openwebui:

image: ghcr.io/open-webui/open-webui:main

container_name: openwebui

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

depends_on:

- ollama

volumes:

- open-webui:/app/backend/data

restart: unless-stopped

volumes:

open-webui:

ollama_data:Ce fichier Docker Compose exécute deux services, ollla et Openwebui. Ollama utilise l’image Olllama / Olllama, écoute le port 11434, désactive l’utilisation du GPU et stocke les données dans le volume OLLAMA_DATA. D’un autre côté, Open WebUI utilise l’image ouverte-webui, Maps Port 3000 à 8080, se connecte à Olllama via son URL de base et enregistre les données dans le volume ouvert-webui. Les deux services redémarrent à moins que les volumes nommés gardent les données persistantes.

Enregistrez le fichier Docker-Compose et démarrez le service Docker:

docker compose up -dAccédez et utilisez Open WebUI

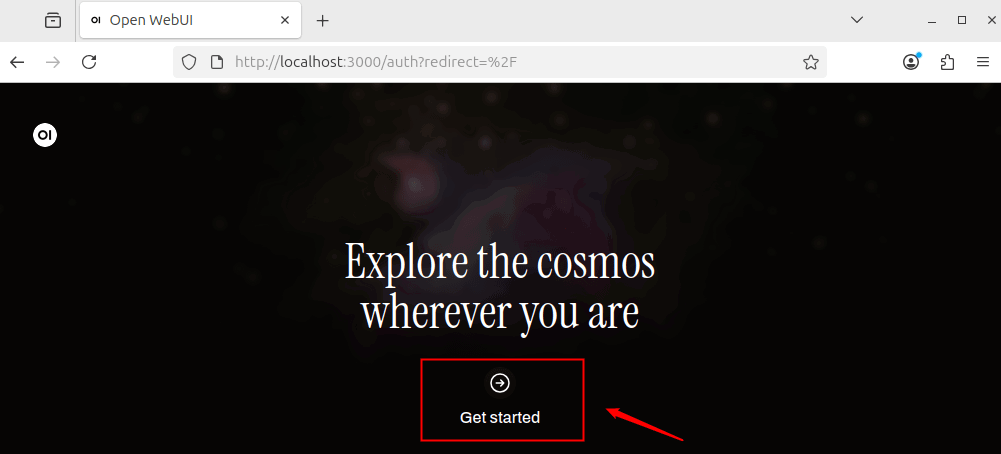

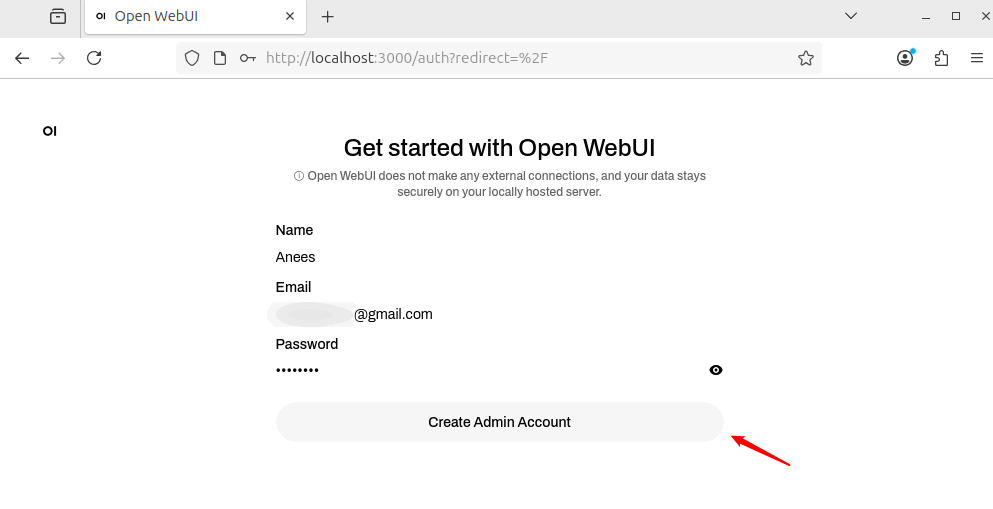

Après avoir commencé les conteneurs, ouvrez un navigateur Web et allez à http: // localhost: 3000. Il chargera l’interface Open Webui de votre machine locale. Cliquez sur le Commencer Bouton pour poursuivre la configuration de l’Open Webui.

Fournissez votre Nom, E-mailet Mot de passepuis cliquez sur le Créer un compte d’administration bouton pour créer votre compte d’administration.

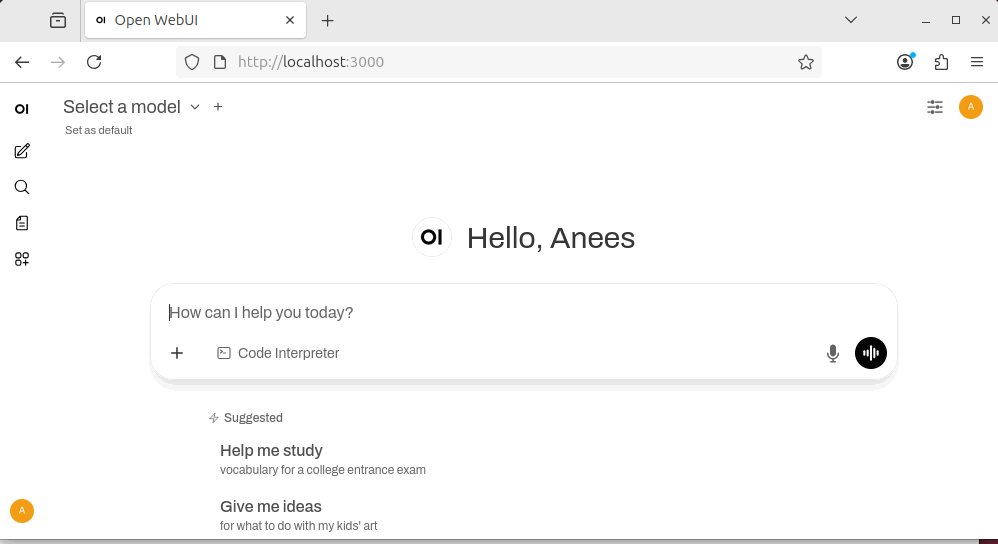

Une fois votre compte créé, vous pouvez ensuite vous connecter pour accéder au tableau de bord.

Installez le modèle AI via Olllama

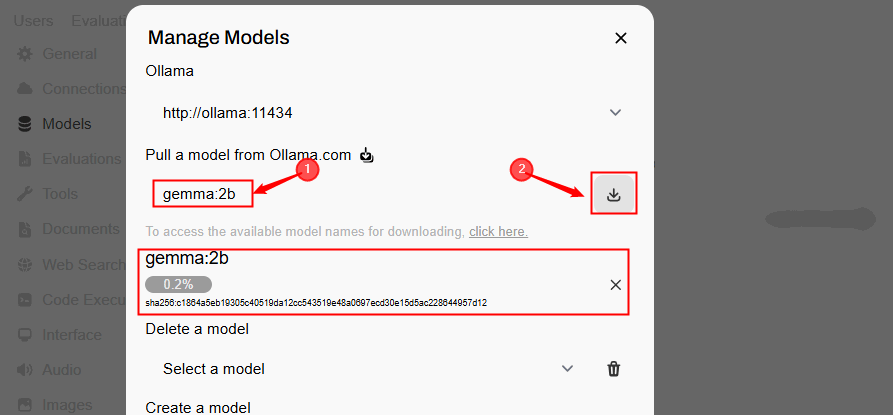

Open WebUI fournit uniquement l’interface. Vous devez toujours installer au moins un modèle d’IA local pour qu’il fonctionne. Heureusement, Open Webui facilite le faire via Olllama. Vous pouvez installer différents modèles, tels que Llama3, Mistral, Gemma ou Vicuna, en fonction de vos besoins et de vos ressources système.

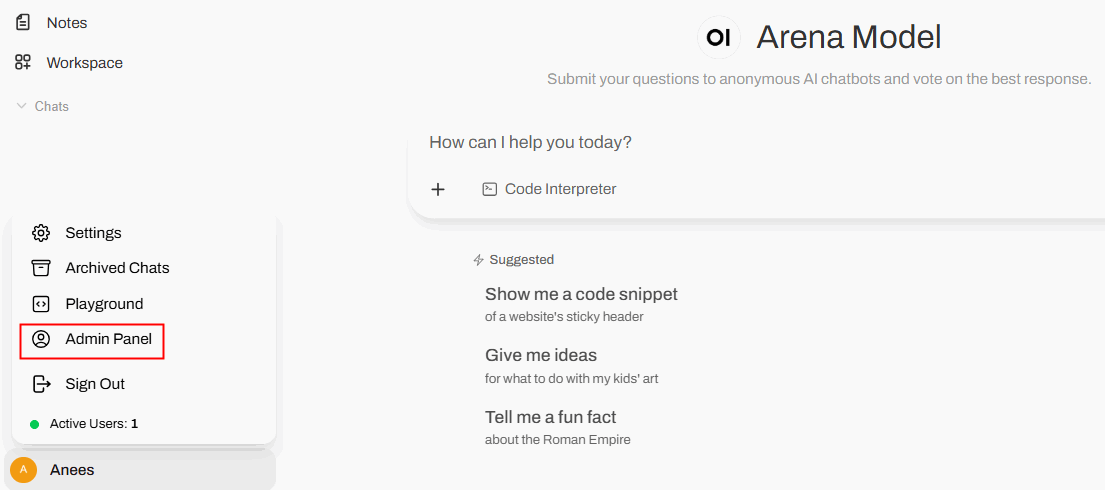

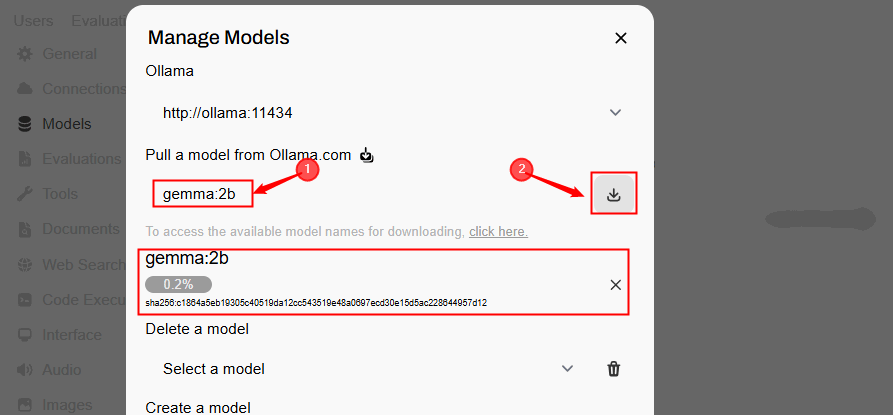

Dans cet exemple, nous installons Gemma: 2b Parce qu’il est plus économe en ressources par rapport aux modèles plus grands. Pour ce faire, cliquez sur votre icône de profil et sélectionnez le Panneau d’administration Option pour accéder au tableau de bord de gestion.

Cliquez sur Télécharger l’icône Dans le coin supérieur droit pour télécharger le modèle.

Spécifiez le nom du modèle et cliquez sur le Bouton de téléchargement.

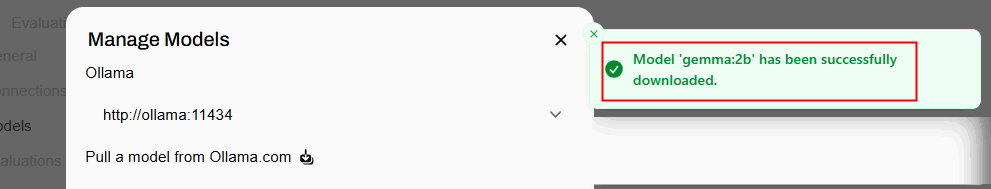

Une fois votre modèle téléchargé avec succès, vous serez informé du message de réussite, comme indiqué ci-dessous:

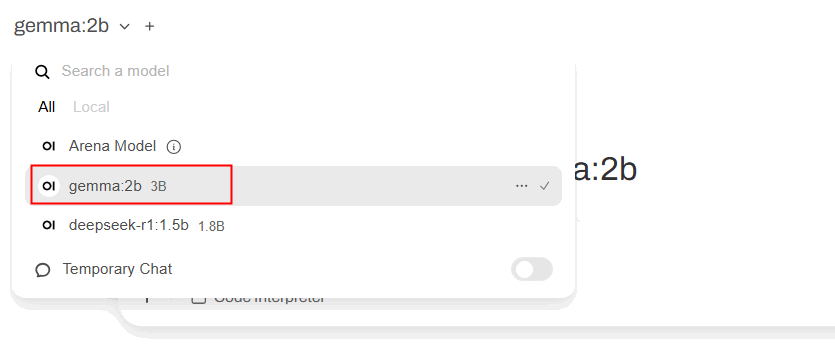

Maintenant tu peux simplement Sélectionnez un modèle à partir de l’interface Open Webui et commencez à l’utiliser pour vos requêtes.

Comment utiliser Open Webui

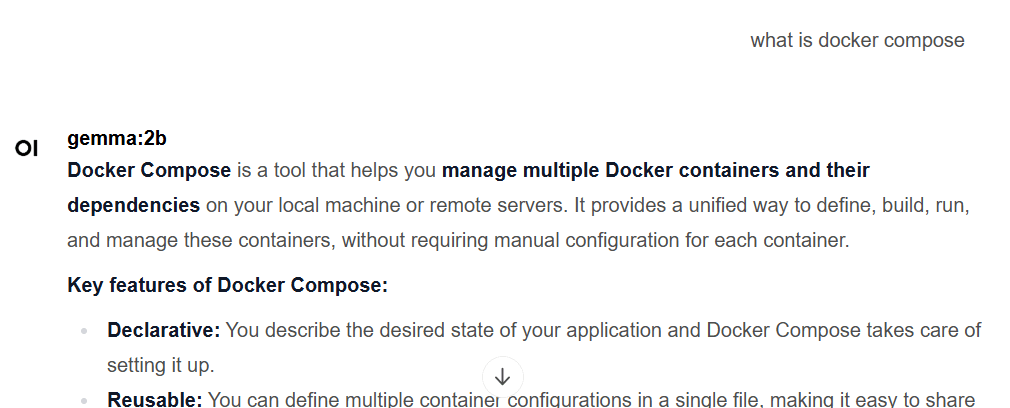

Une fois que vous avez sélectionné un modèle, vous pouvez Commencez à poser des questions. Par exemple, j’ai demandé « Qu’est-ce que Docker composé? » et Open WebUI a renvoyé la réponse suivante:

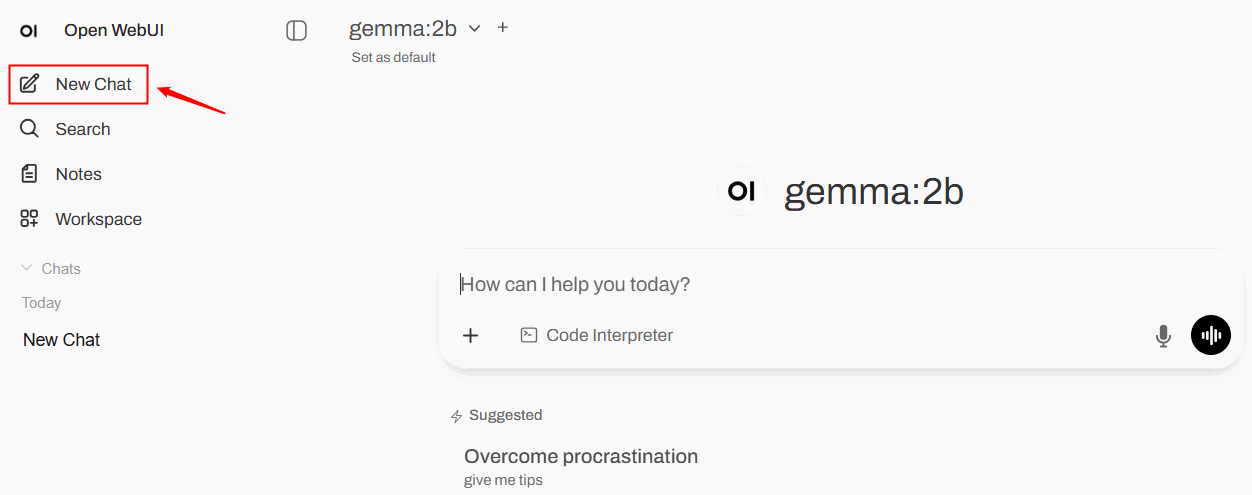

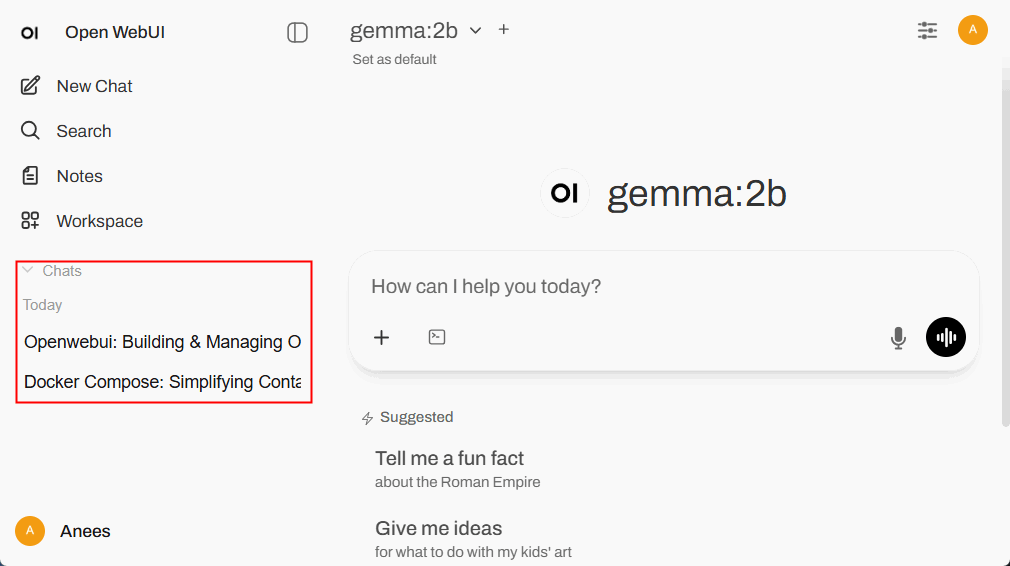

Faire un clic Nouveau chat Dans le menu de gauche pour démarrer une nouvelle conversation sans reporter les messages ou le contexte précédents. Cette fonctionnalité est utile lorsque vous souhaitez discuter d’un sujet complètement différent sans influence des chats antérieurs.

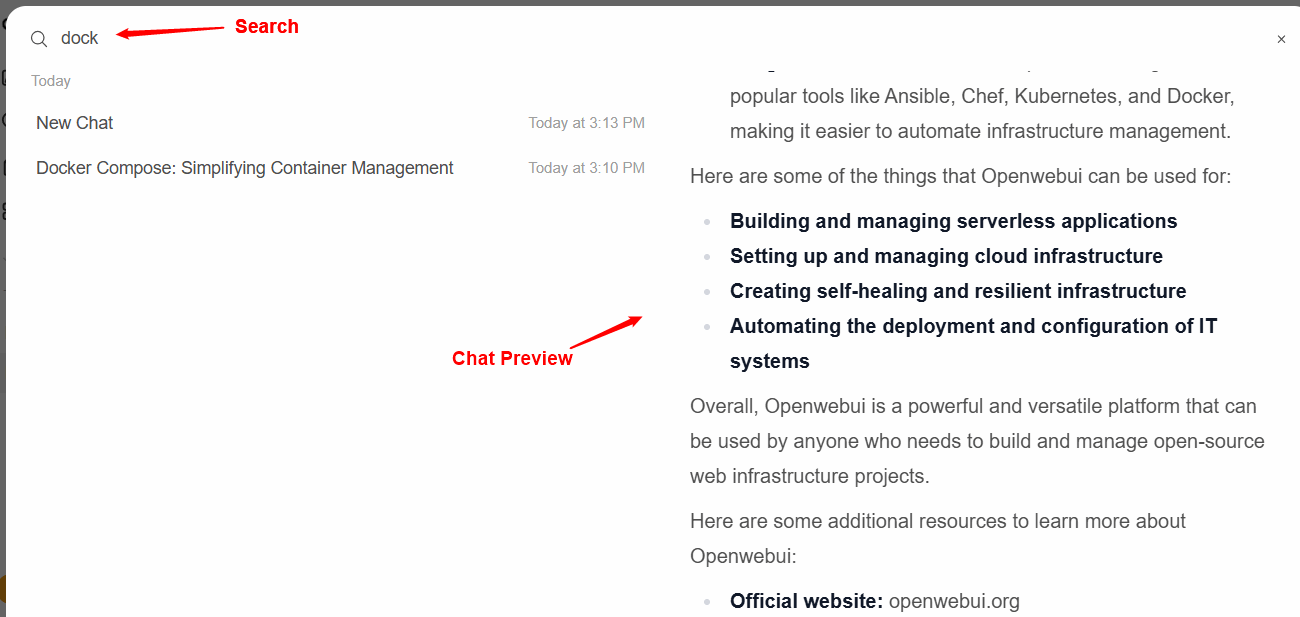

Le Section de recherche Vous permet de trouver des conversations passées ou des mots clés spécifiques dans vos chats enregistrés. À cette fin, vous pouvez taper un mot ou une phrase, et il filtre les résultats pour vous aider à revisiter rapidement de vieilles réponses ou invites.

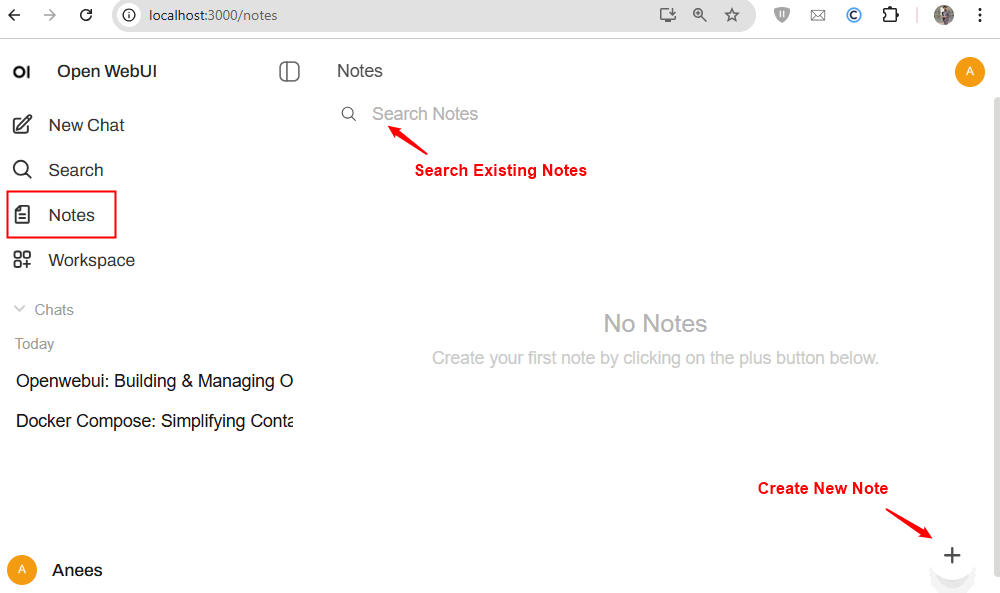

Une autre fonctionnalité utile est Notes. Il s’agit d’un bloc-notes intégré pour stocker du texte, des idées ou des références. Il fonctionne séparément des chats, de sorte que son contenu n’est pas utilisé comme contexte de conversation à moins que vous ne le collez dans un chat. Il est idéal pour économiser des rappels, des extraits de recherche ou des invites fréquemment utilisées.

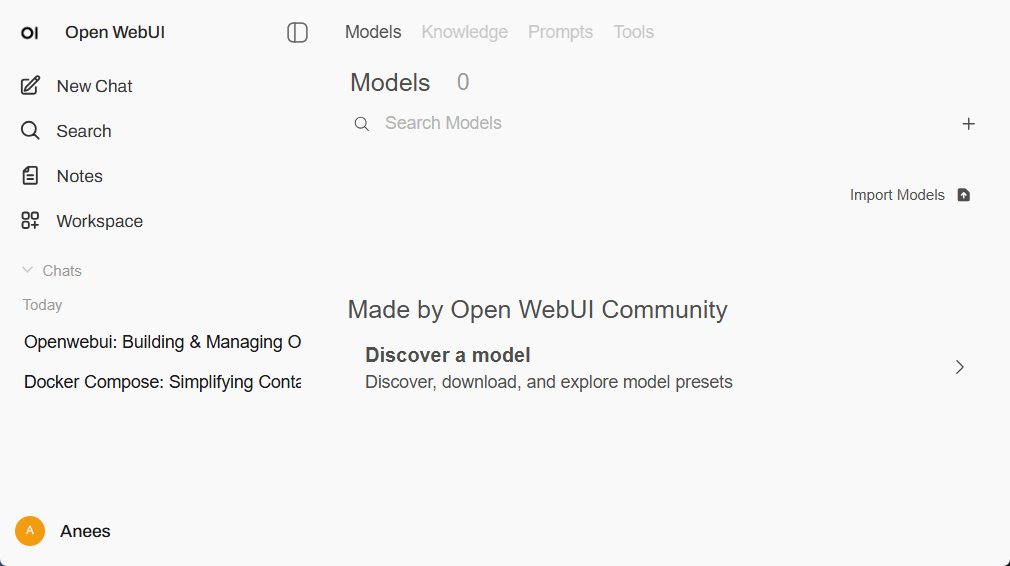

Espace de travail In Open Webui est un espace organisé pour gérer plusieurs projets sans les mélanger. Il est utile pour le codage, l’écriture ou le travail à long terme. L’Open WebUI comprend les onglets suivants:

- Onglet Modèles Découvre et télécharge des modèles ou préréglages communautaires, importe des modèles à partir de sources externes et configure des modèles installés.

- Onglet Knowledge Parcourez les packs de connaissances communautaires ou importez vos propres fichiers (PDF, texte, CSV) pour que l’IA puisse utiliser lorsque vous répondez aux questions.

- Onglet Invite Découvre les modèles communautaires, importe des invites et les réutilise entre les chats.

- Le Onglet des outils Trède ou importe des outils comme des exécuteurs de code, des grattoirs ou des résumés, et les utilise directement dans les chats pour l’automatisation ou les tâches spécialisées:

Chat Montrez votre histoire de conversation avec l’IA. Vous pouvez rouvrir les discussions passées pour les continuer ou en supprimer celles dont vous n’avez plus besoin:

Contrôles de chat dans Open Webui

Le Contrôles de chat Le panneau vous permet d’ajuster la façon dont l’IA réagit dans une conversation. Vous pouvez définir un Invite du système Pour guider la tonalité ou le comportement, et affiner les paramètres avancés comme les réponses de chat en streaming, la taille des morceaux, l’appel des fonctions, les graines, la séquence d’arrêt, la température et l’effort de raisonnement. Chaque paramètre peut être personnalisé ou laissé à sa valeur par défaut pour un comportement standard.

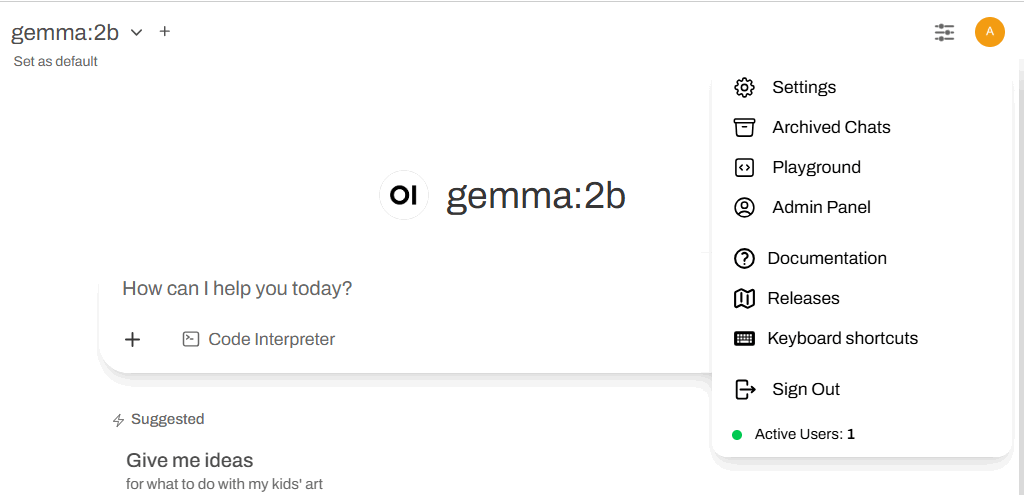

Cliquez sur icône de profil Pour accéder au menu utilisateur, qui comprend des options de paramètres, des chats archivés, de l’aire de jeux, du panneau d’administration, de la documentation, des versions, des raccourcis clavier, de la déconnexion et de la visualisation des utilisateurs actifs.

Emballage

L’auto-hébergement Open WebUI nécessite une configuration initiale, mais une fois configuré, il offre un contrôle complet, une confidentialité et une flexibilité. Vous pouvez choisir des modèles, utiliser vos propres données et personnaliser l’interface, le tout sans compter sur des serveurs tiers. Une fois le modèle installé localement, vous pouvez l’exécuter entièrement hors ligne, tout comme l’exécution de l’agent Gemini CLI AI dans votre terminal.