Table des matières

L’exécution d’un LLM (modèle d’apprentissage des langues) sur votre PC Windows est devenu beaucoup plus facile grâce à l’outil d’IA local de la fonderie de Microsoft. Il est entièrement gratuit et offre une grande variété de modèles d’IA à choisir.

Qu’est-ce que la fonderie locale AI

Microsoft a récemment annoncé que Foundry Local, qui est principalement conçu pour les développeurs. L’outil gratuit vous permet d’exécuter des LLM sur votre PC localement, aucun Internet nécessaire. Vous n’obtiendrez pas les mêmes résultats que vous le feriez avec les outils d’IA basés sur le cloud populaires, tels que Chatgpt, Gemini ou Copilot, mais c’est toujours une façon amusante d’expérimenter avec les modèles d’IA.

Comme il est encore nouveau et techniquement dans un aperçu public uniquement, il est toujours assez basique, alors ne vous attendez pas à ce que ce soit époustouflant. Au fil du temps, Foundry Local ira probablement mieux et aura plus de fonctionnalités.

En rapport: Autre que la fonderie locale, vous pouvez utiliser ces méthodes pour configurer vos propres chatbots AI hors ligne.

Prérequis locaux de la fonderie

Avant d’installer quoi que ce soit, assurez-vous que votre PC est capable de gérer les modèles d’IA locaux de fonderie. Oui, idéalement, Microsoft veut que vous ayez un copilote + PC haut de gamme, mais ce n’est pas nécessaire.

Vous aurez besoin:

- Version 64 bits de Windows 10 ou 11, Windows Server 2025 ou MacOS

- Espace de disque dur de 3 Go, bien que 15 Go soit recommandé, surtout si vous utilisez plusieurs modèles

- 8 Go de RAM, bien que 16 GMB soit recommandé pour de meilleurs résultats

- Bien que non requis, Microsoft recommande d’avoir Nvidia GPU (2 000 séries ou plus récent), Qualcomm Snapdragon X Elite (8 Go ou plus de mémoire), AMD GPU (6 000 séries ou plus récents), ou Apple Silicon

Vous n’aurez besoin d’accès qu’Internet pendant l’installation et lors de l’installation d’un nouveau modèle d’IA. Après cela, n’hésitez pas à vous déconnecter. Assurez-vous également d’avoir des privilèges d’administration pour installer Foundry Local.

Comment installer une fonderie locale AI

Contrairement à de nombreuses applications, vous n’avez pas besoin d’aller sur un site Web ou du Microsoft Store pour installer Foundry Local. Au lieu de cela, vous utiliserez un Winget, qui vous permet d’installer un logiciel via une invite de ligne de commande. Ne vous inquiétez pas, vous n’avez pas besoin d’être développeur ou maître de la ligne de commande pour faire tout cela.

Si vous préférez une installation plus traditionnelle, téléchargez-la depuis GitHub.

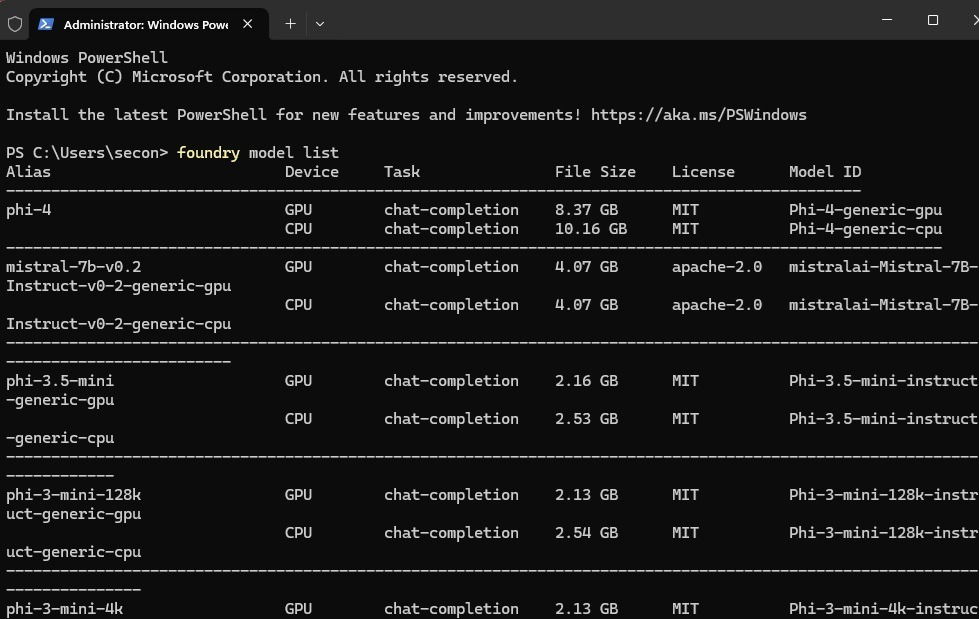

Pour Windows, ouvrez une fenêtre de terminal. Presse Gagner + X et cliquer Terminal (Admin). Entrez la commande suivante:

winget install Microsoft.FoundryLocalAcceptez les conditions et attendez que l’installation se termine. Cela peut prendre quelques minutes.

Pour macOS, ouvrez une fenêtre de terminal et entrez ce qui suit:

brew tap microsoft/foundrylocal

brew install foundrylocalSi vous préférez télécharger un LLM sur un Raspberry Pi, essayez ces étapes.

Installation de votre premier modèle d’IA

Pour la première fois, Microsoft recommande un modèle de poids léger – le PHI-3,5-moins. Vous n’avez pas à commencer par celui-ci, mais si vous manquez d’espace, c’est un bon moyen d’essayer les choses sans sacrifier un stockage précieux.

Ouvrez une fenêtre de terminal et entrez la commande suivante:

foundry model run phi-3.5-miniCela peut prendre plusieurs minutes ou plus, selon le modèle que vous choisissez. Pour moi, ce modèle particulier n’a pris que deux minutes. La meilleure partie est que la fonderie locale AI installe la version optimale du modèle pour votre configuration matérielle, vous ne trouvez donc pas exactement quoi installer.

Si vous souhaitez essayer d’autres modèles, consultez la liste complète en utilisant la commande suivante:

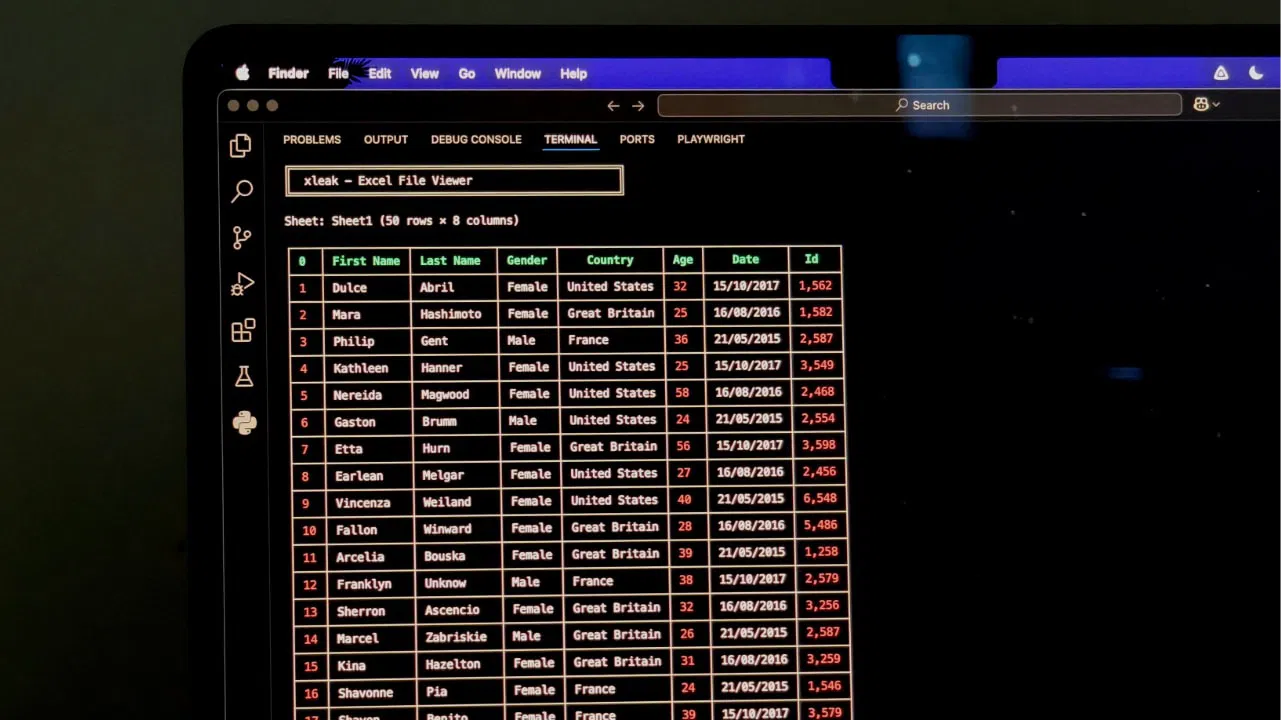

foundry model listChaque modèle de la liste montre la quantité de stockage dont il a besoin et son objectif. Pour l’instant, chaque modèle est juste pour l’achèvement du chat.

Interagir avec les modèles d’IA locaux

Il n’y a pas une interface graphique pratique pour interagir avec les modèles AI que vous installez. Au lieu de cela, vous ferez tout à partir de la ligne de commande. Mais, ce n’est pas très différent que de discuter avec un autre chatbot d’IA. Entrez simplement votre texte lorsque vous voyez l’invite Mode interactif, veuillez saisir votre texte.

Chaque modèle d’IA a ses propres limites. Par exemple, j’ai entré une invite pour PHI-3,5-Mini en demandant «Qu’est-ce que la fonderie locale.«Je l’ai fait spécifiquement pour souligner le fait que les connaissances de ce modèle sont limitées au début de 2023 et plus tôt. Le résultat mentionne cette limitation, mais tente de répondre au mieux que possible.

Pour de meilleurs résultats, respectez les questions simples qui ne nécessitent pas beaucoup de recherches ou de connaissances actuelles / brisantes.

Si vous souhaitez basculer entre les modèles que vous avez déjà installés, utilisez l’invite suivante:

foundry model run modelnameRemplacez simplement « ModelName » avec votre modèle préféré.

Si vous êtes en mode interactif, alias en mode de chat, vous devrez quitter la fenêtre du terminal et démarrer une autre session. Actuellement, il n’y a pas de commande de sortie, qui est certainement une fonctionnalité nécessaire.

Commandes d’IA locales de fonderie que vous devez savoir

Bien qu’il y ait une liste que vous pouvez consulter, vous n’avez vraiment besoin que de connaître une poignée de commandes pour utiliser Foundry Local. Ces commandes vous montrent toutes les commandes disponibles dans chacune des trois catégories principales – modèle, service et cache.

Voir toutes les commandes locales de fonderie générale avec:

foundry --helpPour les commandes du modèle, utilisez:

foundry model --helpPour les commandes de service, utilisez:

foundry service --helpPour les commandes de cache, utilisez:

foundry cache --helpTant que vous vous en souvenez, vous n’avez pas vraiment besoin de la liste complète. Mais gardez à l’esprit que les nouvelles commandes seront probablement ajoutées au fil du temps car Microsoft s’appuie sur le service. Pour l’instant, considérez-le plus un test bêta qu’un outil à part entière.

Si vous avez besoin de plus que Foundry Local ne peut fournir, restez avec Chatgpt ou ces alternatives. Ou, essayez ces outils d’IA pour améliorer votre vie et votre productivité.